扩散模型应用·寻找语义空间

封面来自 CivitAI.

Diffusion Autoencoders

CVPR 2022 2021.11.30

尽管扩散模型的生成效果非常好,但是它缺乏有语义的隐空间,给一些下游应用带来了麻烦。即便是 DDIM 的确定性采样过程,其隐空间,即

Semantic encoder 是一个卷积编码器,目的是提取输入图像的语义特征

现在,如果我们想用 Diffusion AE 做无条件生成,会发现一个问题——不知道

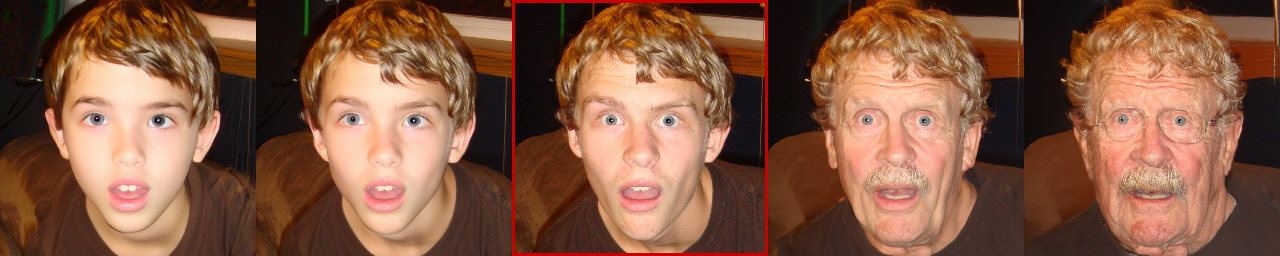

说了这么多,这个隐空间究竟是不是像作者声称的这么好,还得实验来证明——

- 在第一个实验中,作者固定

- 在第二个实验中,作者在隐空间中插值(

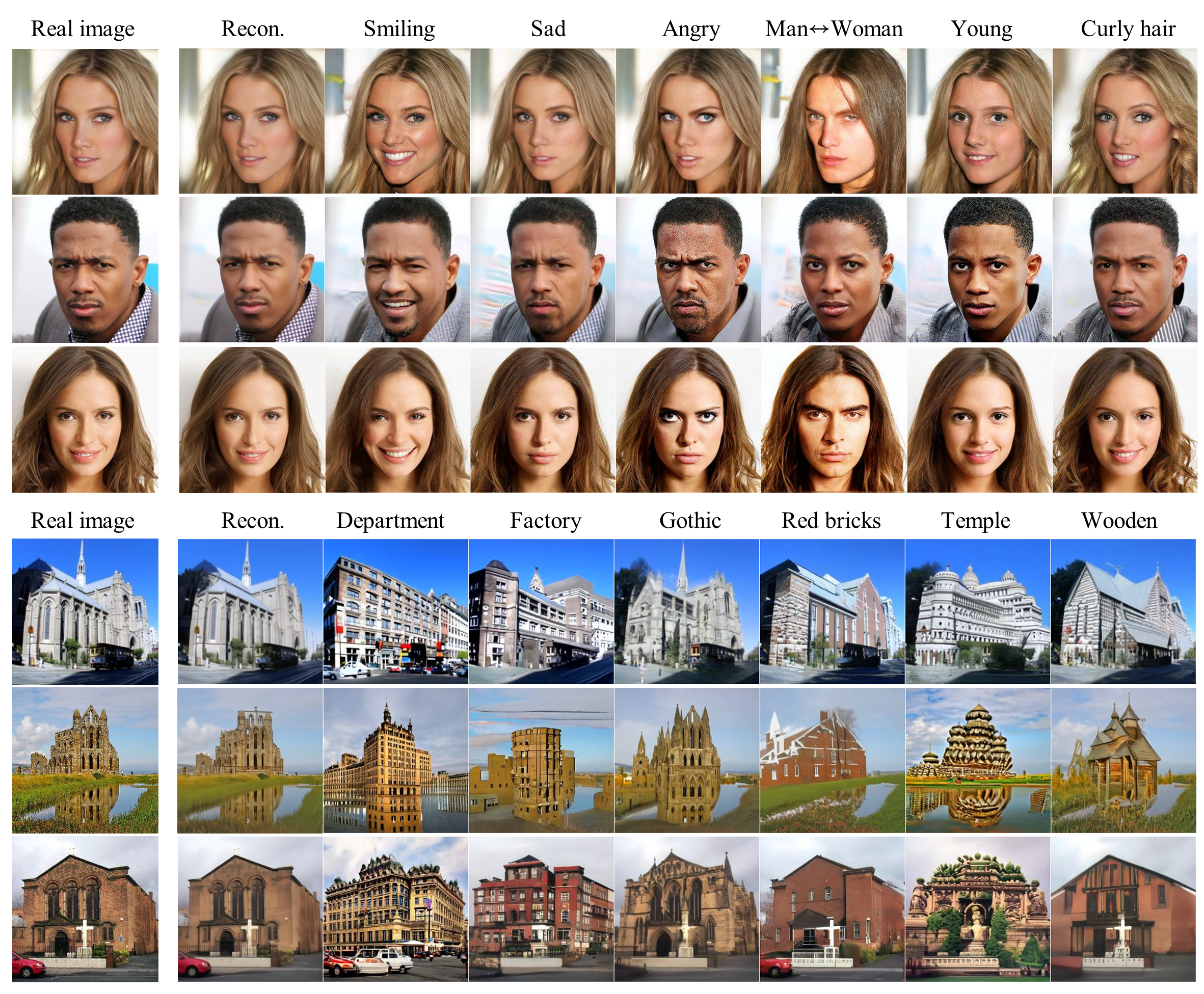

- 前两个实验证明作者设计的隐空间的确非常优秀,于是我们可以依靠它来编辑图像属性。通过在

- 第四个实验作者定量比较了 Diffusion AE 和其他生成模型的重构性能,并消融了不同大小的

- 从扩散模型的角度,Diffusion AE 能够“加快”去噪。这里的加快不是指减小时间步,而是指

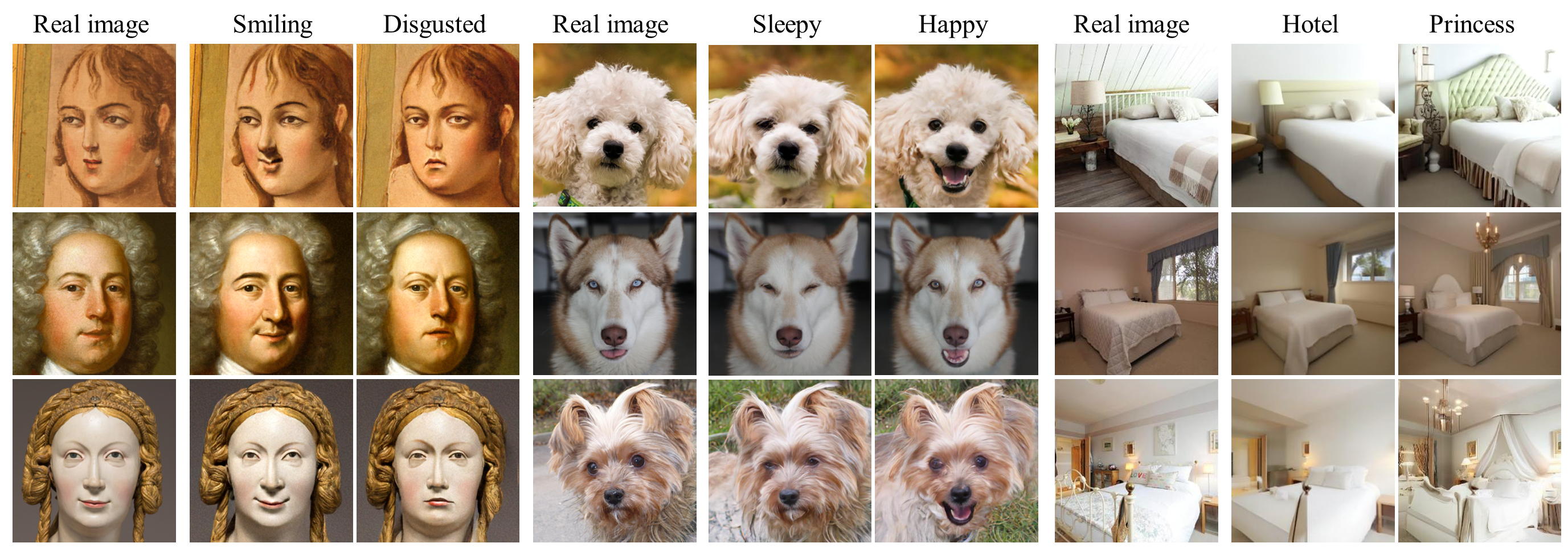

- 作者进一步探索了 few-shot conditional 生成。给定目标类别的分类器

- 最后测试无条件生成的性能,证明 Diffusion AE 相比一般的扩散模型并不会对图像质量带来损失。

点击查看 Diffusion Autoencoders 的生成样例(摘自官网)

Asyrp

ICLR 2023 notable top 25% 2022.10.20

这篇论文的名字其实叫做 Diffusion Models already have a semantic latent space,也是相当直白了。具体而言,设隐变量为

- 同质性:对于不同的样本,同样的

- 线性:改变

- 健壮性:

- 时间一致性:对于扩散模型来说,各个时间步下

之前的工作 Diffusion Autoencoders[1] 通过训练一个编码器来人为构造了一个隐空间,而本文作者指出——训练好的扩散模型本身就有一个有语义的隐空间了,不需要专门去学习一个,这个隐空间就是 U-Net 的 bottleneck 的输出,作者称之为 "h-space"(我猜取这个名字是因为大家在写代码的时候喜欢把中间层变量命名为

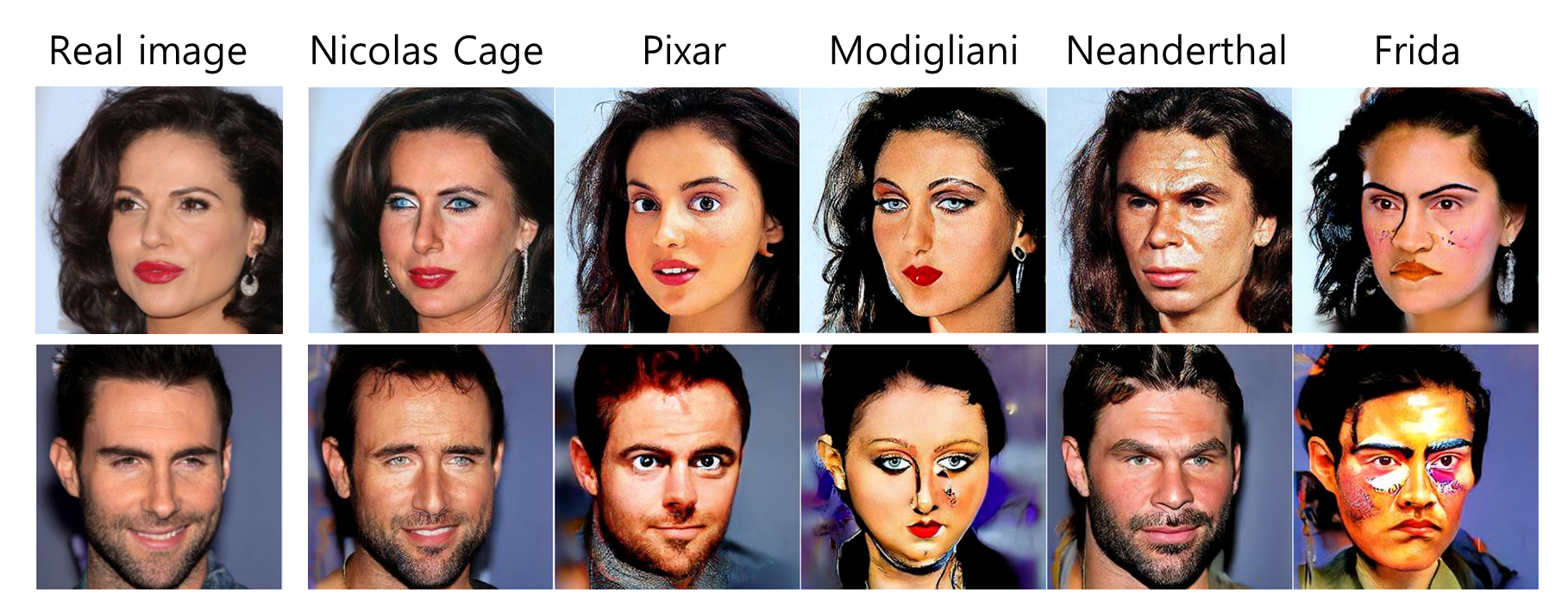

如图所示,作者在 h-space(就是预训练扩散模型的 U-Net 的 bottleneck 输出)后面用一个可学习的小网络

本文另一个贡献是把逆向采样过程分成了三段:前期用改动的网络做 DDIM 采样来编辑;中期编辑得差不多了,就用原本的网络做 DDIM 采样;后期切换成 DDPM 采样来增加随机细节、提升图像质量。至于什么时候切换不同的采样方式,作者提出了两个指标分别量化编辑强度和采样质量,此处不再赘述,感兴趣的读者可以参看论文 Section 4.

最后,读者可能想问标题的 Asyrp 是什么、上图中的

点击查看 Asyrp 的生成样例(摘自官网)

References

- Preechakul, Konpat, Nattanat Chatthee, Suttisak Wizadwongsa, and Supasorn Suwajanakorn. Diffusion autoencoders: Toward a meaningful and decodable representation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 10619-10629. 2022. ↩︎

- Kwon, Mingi, Jaeseok Jeong, and Youngjung Uh. Diffusion models already have a semantic latent space. arXiv preprint arXiv:2210.10960 (2022). ↩︎