扩散模型应用·基于文本的图像编辑

封面来自 CivitAI.

DiffusionCLIP

CVPR 2022 2021.10.06

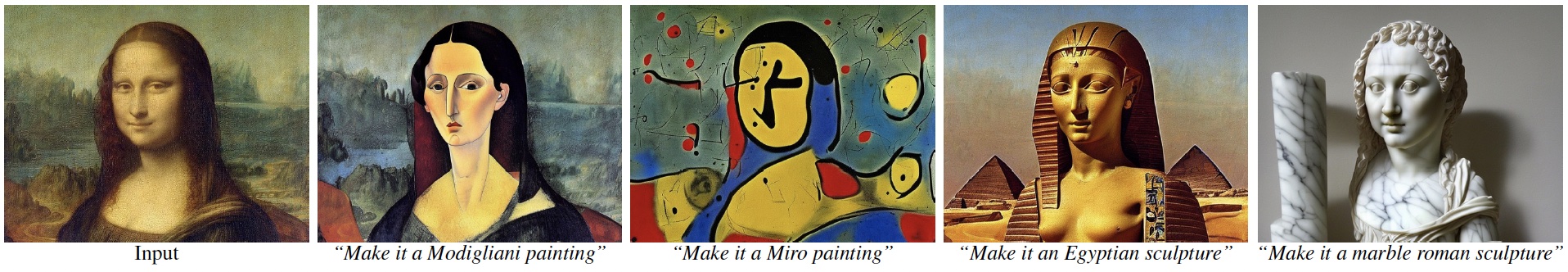

DiffusionCLIP[1] 旨在用文本编辑图像,之前人们常使用 GAN inversion + CLIP 来做这个任务,但是作者指出 GAN inversion 的能力有限,难以重建原图中在训练集里不常见的部分(比如文章开篇大图展示了一个人把手放在了脸旁,但是 GAN inversion 会把手给去掉,因为大多数训练数据都没有手)。因此,作者希望利用 Diffusion Models 几近完美的重建能力(DDIM)来解决这个问题。

如下左图所示,作者首先用 DDIM inversion 将待编辑的图像转换到隐空间,然后用 CLIP 来微调 score function.

损失函数包含两部分:

Directional CLIP loss:

Identity loss:

我们知道扩散模型是分时间步生成的,梯度传播过程可能不是那么直观,所以作者还贴心地绘制了梯度流以供参考,见上右图。在训练完成后,任何输入图像都能被编辑到

进一步地,如果源图像不在训练分布之中,我们还能用 DDPM 前向过程编码,然后用微调的 DDIM 逆向过程来生成;我们还能连接多个前向-逆向过程来编辑图像;还能直接融合多个不同微调模型的输出来同时编辑多个属性……总之根据不同的应用场景,怎么应用是比较灵活的,如下图所示。

然而,DiffusionCLIP 有一个致命的缺点,即对于每个

点击查看 DiffusionCLIP 的生成样例(摘自官方 repo)

Blended Diffusion

CVPR 2022 2021.11.29

Blended Diffusion[2] 关注的是用文本指导修改指定区域的内容,可以看作是 inpainting 的升级版。具体而言,给定一张图像

为了让文本引导图像生成,作者借鉴了 classifier guidance 的做法,但将引导项改成了:

CLIP 引导使得掩码内图像符合文本描述,但并不能保证掩码外内容不变。因此,作者又设计了一个针对掩码外内容的引导项:

Algorithm 1 分别保证了掩码内外内容都是我们希望的,但并没保证二者能很好地融合在一起。为此,作者充分利用了扩散模型的特点,设计了一个针对 inpainting 任务的采样模式:在每一个时间步,对于掩码内的部分,我们使用扩散模型给出的结果不变;对于掩码外的部分,我们用原图的加噪结果代替(事实上,这个做法早在宋飏刚提出 NCSN 的论文[5]的附录 B.3 里就有所阐述)。这样,虽然当前步依旧不能保证掩码内外的一致连贯性,但下一步能迫使图像向一致连贯的方向生成。另外,这种模式自然满足了掩码外的图像不会被改变的要求,因此我们也不必使用 Algorithm 1 中的

Mask Guidance

有些人将这种针对 image inpainting 的采样模式称为 mask guidance,因为它和 classifier guidance 具有类似的形式。沿用上图记号,即

另外,论文还提出了 extending augmentations 来增加模型的鲁棒性,以及最后对结果依 CLIP 相似度排序,这里不过多赘述。

话说,这篇论文里展示的效果感觉一般,修改的地方好似贴图,有点违和。另外,其生成的区域甚至还带有噪点,可能是代码哪里有点 bug 吧。

点击查看 Blended Diffusion 的生成样例(摘自官方 repo)

SDG (Semantic Diffusion Guidance)

WACV 2023 2021.12.10

SDG[3] 可以看作是 classifier guidance 的直接推广,支持用文本、图像或二者共同来指导模型的生成。具体而言,原始的 classifier guidance 是用

首先来看文本引导。作者利用 CLIP 模型,设置引导函数为图像、文本特征的点积:

由于扩散模型中的每一个 noise level 都要做引导,所以这个 CLIP 模型的图像编码器需要在 noised data 上训练。为此,作者特别提出了一种自监督的微调方法,不需要使用文本数据。设预训练的图像编码器为

关于图像引导,作者将其分为了两个方面:图像内容引导和图像风格引导。对于内容引导,设引导图像为

这里的

对于风格引导,我们可以匹配各个特征图的 Gram 矩阵:

总而言之,SDG 的关键点就在于设计引导函数

SDG 与 ILVR 的联系

我们在介绍 ILVR[6] 时说(见扩散模型应用·图生图与图像恢复),ILVR 本质和 classifier guidance 是一致的。那么,SDG 作为 classifier guidance 的推广形式,自然也能导出 ILVR. 事实上,对比二者的引导形式,它们的联系还是挺显然的:

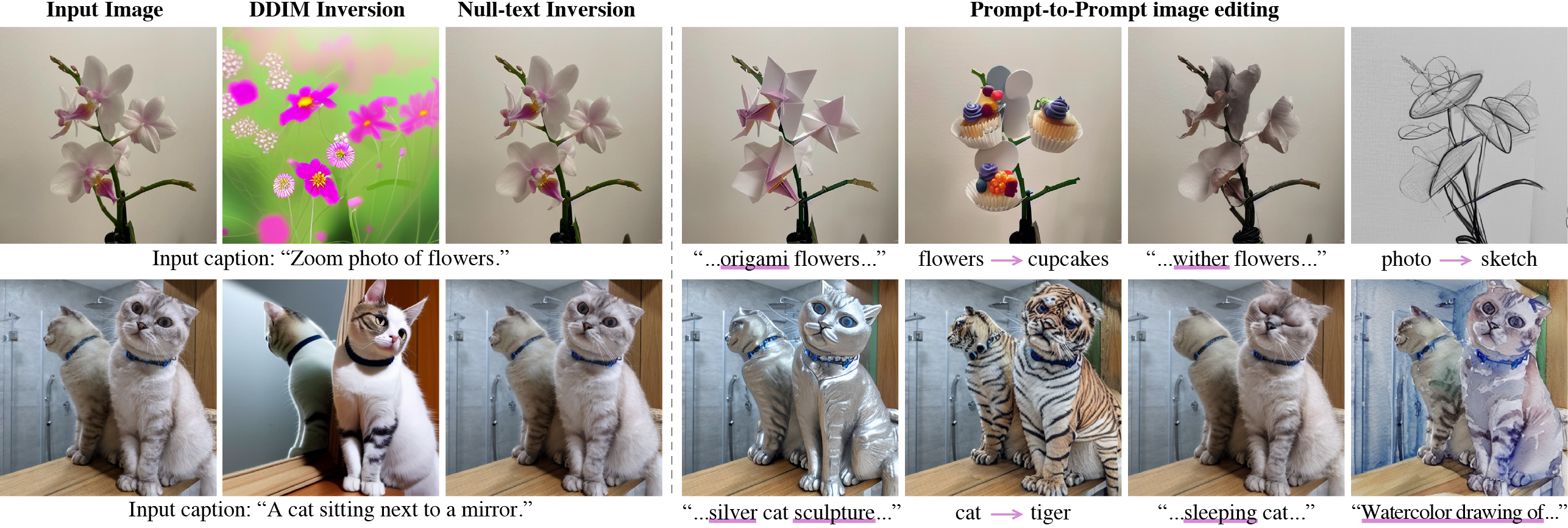

Prompt-to-Prompt

Google 2022.08.02

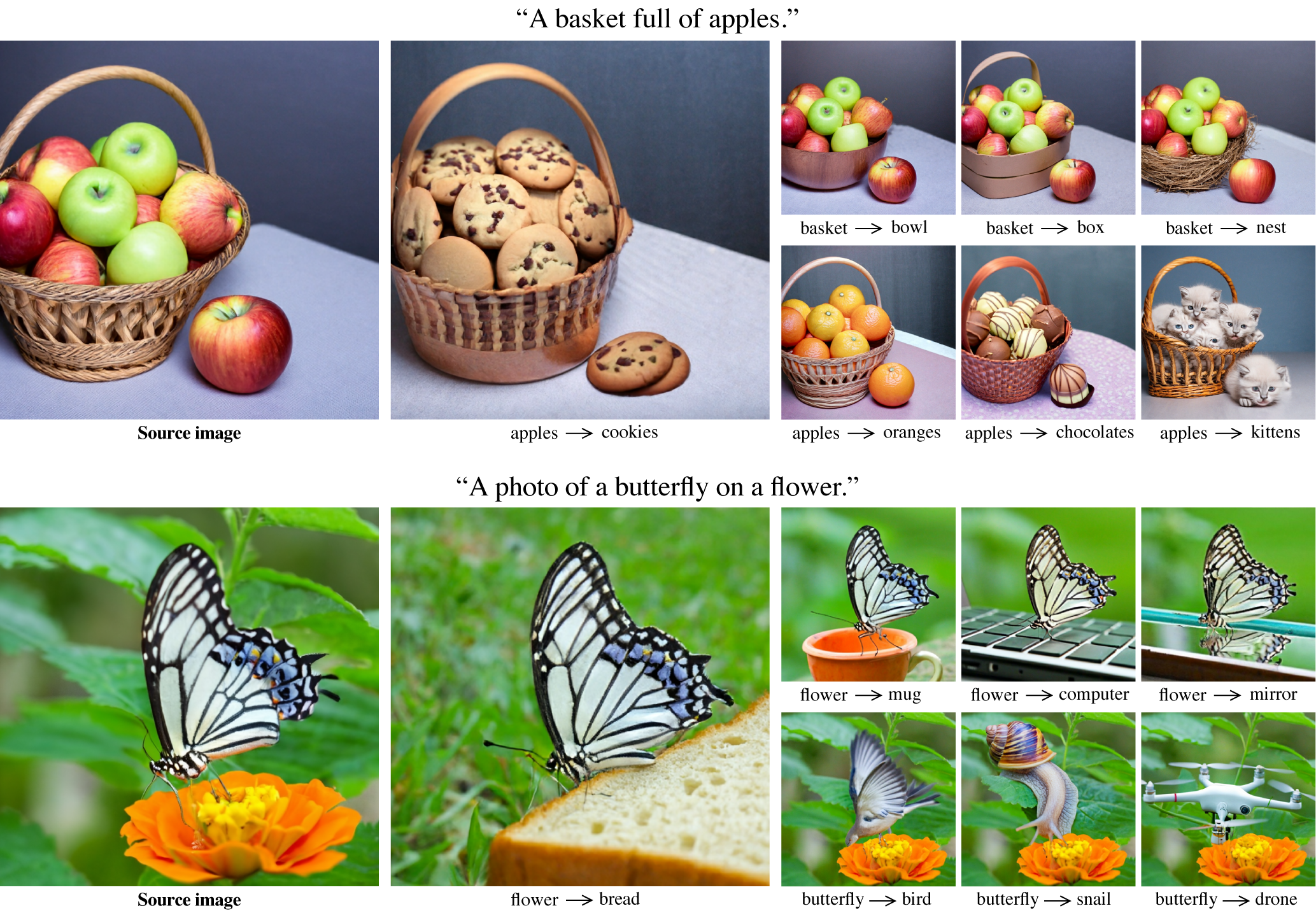

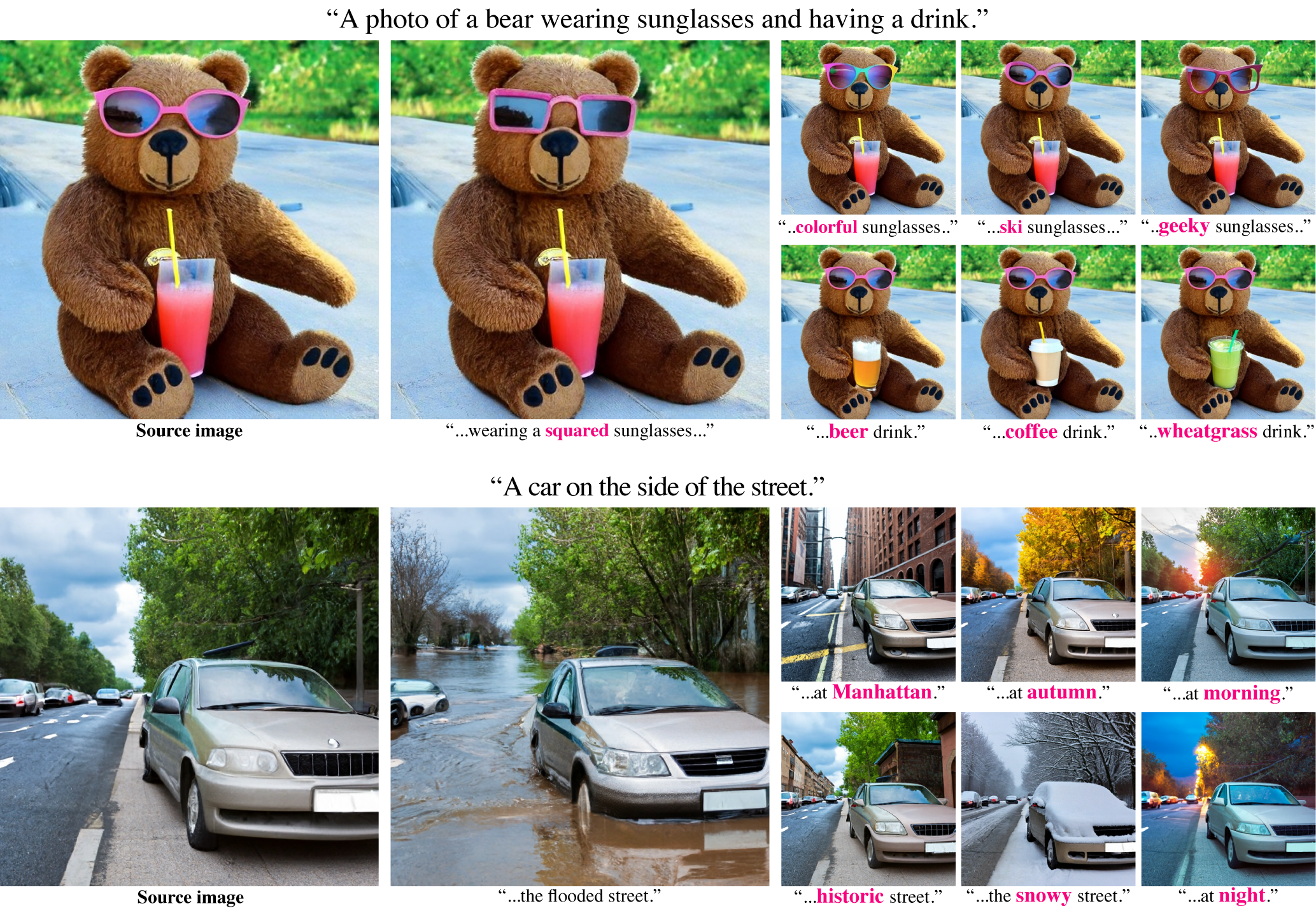

GLIDE、DALL·E 2、Imagen 等 large-scale language-image models 展现出了令人惊叹的生成能力,但是用它们来做图像编辑却不是一件容易的事,因为对 prompt 的微小改动会导致生成完全不一样的图像。因此,这些模型往往需要用户给定一个 mask 指示需要更改的区域。然而,绘制 mask 一方面多少带来了一些不便,另一方面 mask 掉的区域将被完全无视,丢弃了可能是很重要的信息,导致应用场景受限,例如用户无法更改一个物体的纹理。因此,Prompt-to-Prompt[7] 致力于不需要 mask 的图像编辑方法。

作者探究发现,网络中的 cross-attention layer 能体现出文本和图像之间的语义联系,如下图所示:

因此,我们可以通过操纵 attention map 来操纵图像语义。具体而言,设原文本描述为

可见,问题的关键在于如何设计编辑函数

换词:例如将

加词:例如将

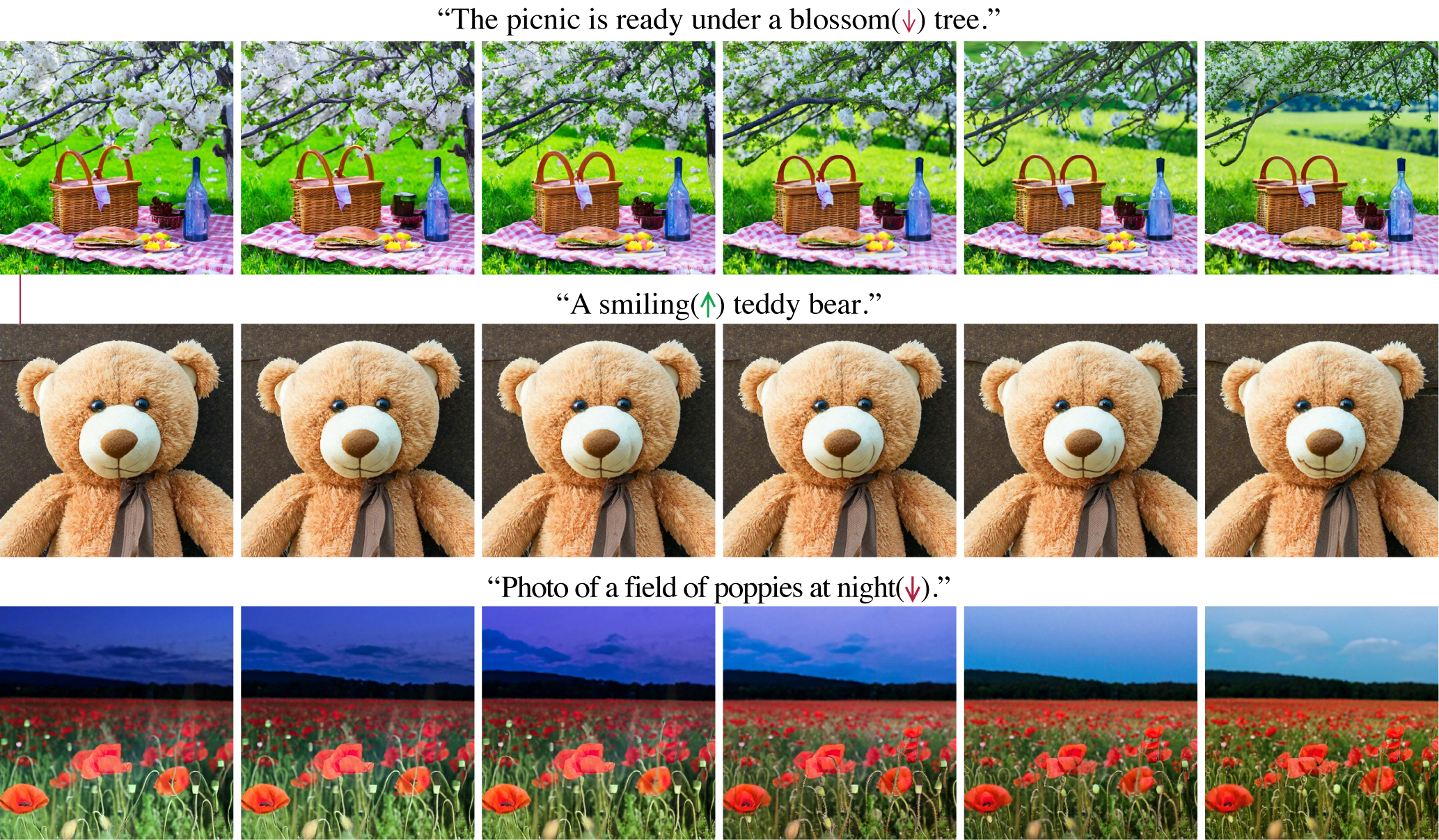

修改某词的权重:例如

基于上述三种编辑方式,作者阐释了更多的应用场景:

- Text-only localized editing:一般而言,换一个名词或者添加形容某物体的形容词就能达到局部修改的效果。

- Global editing:添加一个形容地点、天气、时间等的形容词就能达到全局修改的效果,但是画面的整体结构并不会改变。

- Fader control using attention re-weighing:有时候我们并不好描述一个形容词的程度,例如山上到底有多少雪。这时候修改词权重的方法就给出了很好的解决方案。

- Real image editing:首先使用 DDIM inversion 得到隐变量表示,然后操控 reconstruction 过程. 然而,作者发现在 classifier-free guidance parameter 比较大的时候 DDIM inversion 并不能很好的 reconstruct 原图。为了解决这个问题,作者用 attention map 自动生成 mask 来辅助编辑,但具体怎么做的也没多说。

在 Prompt-to-Prompt 之前,人们要么采用微调(如 DiffusionCLIP)、要么采用 guidance 技巧(如 Blended Diffusion 和 SDG)来实现文本编辑图像,而 Prompt-to-Prompt 首次给出了一个新的思路——更改 backbone 网络的中间值。当然,为了有效地编辑,这种思路要求更改的值容易对应上图像的语义,比如本文的 attention map. 后续非常多的工作都受到了 Prompt-to-Prompt 的影响。

点击查看 Prompt-to-Prompt 的生成样例(摘自官网)

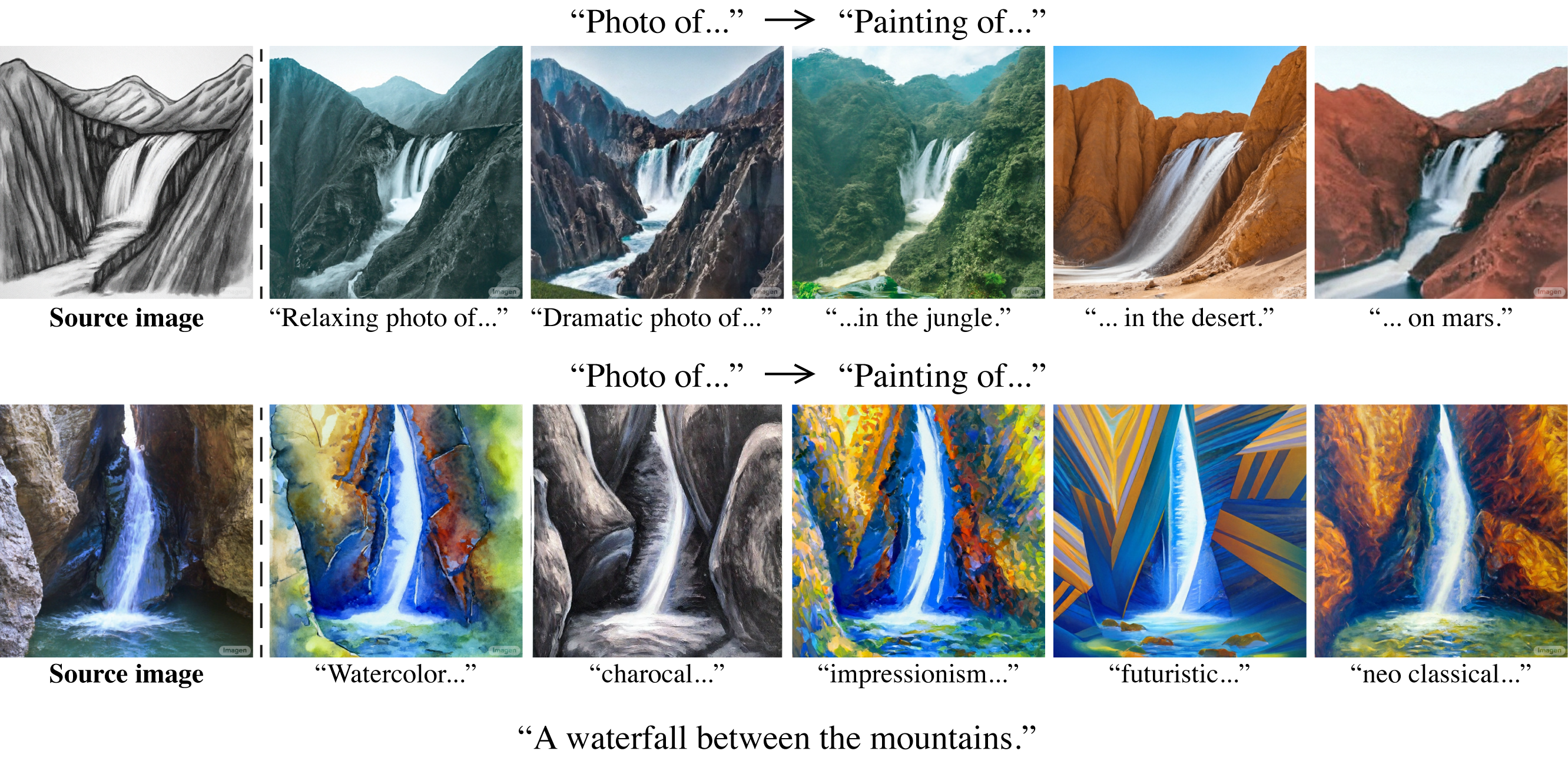

DiffuseIT

ICLR 2023 2022.09.30

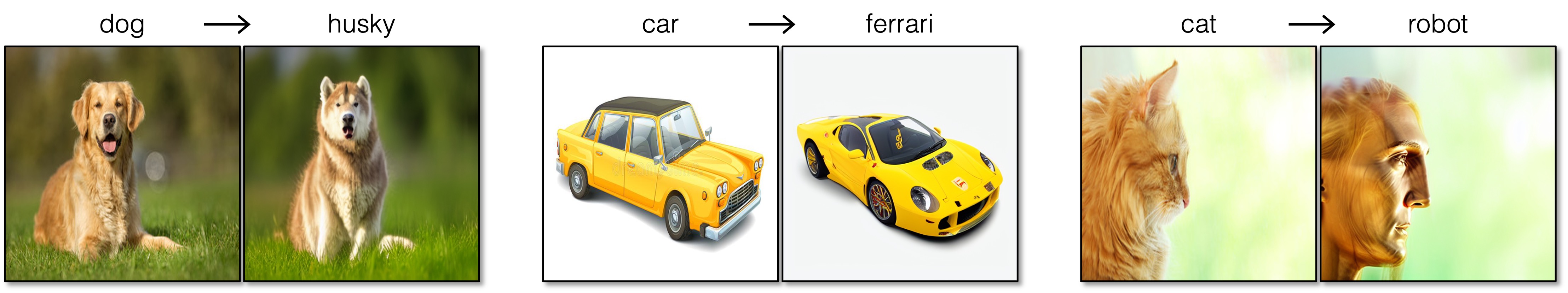

在 Image Translation 中,最大的挑战在于改变图像风格(语义)的同时,保持图像的内容(构图)不变。一种解决方案是为模型输入原始图像作为条件,但这要求我们重新训练或微调模型,而且不能应用于非成对数据的场景。而之前使用预训练无条件模型的方法,如 Blended Diffusion、SDEdit 等,无法保证内容的不变。

DiffuseIT[8] 作者认为,这是因为风格和内容的表征没有显式的解耦,所以改变风格往往也改变了内容。为此,作者想到了 splicing Vision Transformer 发现的一个现象——对于一个预训练 DINO ViT,其多头注意力的 keys

拉近生成图像和源图像的结构信息:

拉近生成图像和目标文本(如果有)的语义信息:

拉近生成图像和目标图像(如果有)的语义信息:

在生成过程的每一步,都推远当前步和上一步的语义信息:

一图以蔽之:

另外还有一些细节,比如在最开始做 resampling,还有一个正则化的引导项,都是借鉴了其他论文的提议,这里不细说了。总之,DiffuseIT 的做法其实没有什么新鲜的,但是看可视化效果,它确实做到了极大程度上保留构图而改变风格,不过这也归功于 splicing ViT 的发现。

虽然 DiffuseIT 把保留构图作为出发动机和核心卖点,但是个人觉得这种性质不一定适合所有的 Image-to-Image Translation. 比如,它非常适合冬天转夏天或者狮子转老虎,但是如果要把狗变成猫,那生成的猫就有个狗一样的长鼻子,长相着实怪异。如果能有个超参数让用户权衡风格与内容的保留程度就更好了。

Imagic

CVPR 2023 2022.10.17

DiffEdit

ICLR 2023 spotlight 2022.10.20

DiffEdit[9] 与 Prompt-to-Prompt[7] 的动机类似,即目前根据文本编辑图像的模型,如 Blended Diffusion、GLIDE 等都存在一些问题:

- 需要提供一个 mask 指定需要更改区域,否则整张图的内容会完全改变;

- mask 会丢弃掉原有内容的重要信息,这些语义信息在编辑时应保留。譬如,将狗变成猫不应该改变其颜色、姿态等。

因此,DiffEdit 旨在只使用文本来编辑图像中需要改变的区域,而不需要用户提供 mask. 其解决问题的思路如下图所示:

如上图所示,DiffEdit 包含三个步骤:首先通过比较两次逆向过程(一次以 ref. text 为条件或不带条件,另一次以 query 为条件)的差异生成 mask,然后通过 DDIM encoding (或称 DDIM inversion、reverse DDIM) 得到隐空间表示,最后加入 query 为条件、并用 mask guidance 方法 decode 得到输出图像。下面我们分别对这三个步骤做阐释。

Compute Mask

在对图像做一定程度的加噪后,用不同文本作为条件让扩散模型去噪,那么理论上两次噪声估计差异较大的地方就是需要编辑的地方。实际操作中,为了让效果更加稳定,作者加噪了

Encoding

依 DDIM encoding 过程走

另外,encoding 用的是无条件模型,或者说取条件为

Decoding with mask guidance

以 query 为条件 decode,并施以 mask guidance:

这里产生了两个问题:

- 理论上我们要用无条件模型才能恢复原图,为什么 DiffEdit 还能够保证 mask 外内容不变?

- 为什么作者称 DiffEdit 在编辑的同时能够保留 mask 内原图的一部分语义信息(比如狗的颜色、姿态)?

这两个问题的关键在于 DiffEdit 用的是 DDIM 确定性编/解码而非 DDPM 的随机编/解码。作者推导了二者解码结果与原图之间的差异的界,发现前者在

Null-text Inversion

Google 2022.11.17

Null-text Inversion[10] 是 prompt-to-prompt 的续作,解决的是如何在真实图像上运用 prompt-to-prompt 的问题。相比合成图像,我们并不知道真实图像的 prompt、也不知道它对应的隐变量是什么,而这两点都是 prompt-to-prompt 需要事先知道的。对于第一个问题,使用现有的一些 image captioning 模型就行;对于第二个问题,最直接的想法就是 DDIM inversion. 然而,作者发现 DDIM inversion 在有 guidance 的情形下并不能较好地重建输入,因此作者希望找到更好的 inversion 方式。

如上图上半部分所示,设 DDIM inversion 过程为

我们现在仔细考虑采样过程的每一步。如上图下半部分所示,classifier-free guidance 会让网络推理两次,分别对应有条件(上分支)和无条件(下分支),二者结果依据

实现上,由于采样过程是随时间步进行的,因此我们要按

虽然对于每一个输入的真实图像都要跑一遍上述训练算法来做 inversion,但是作者称在 1 块 A100 上只需要 1min 就能得到较好的结果,还是能接受的。

总结一下,Null-text inversion 的亮点在于它揭示了 classifier-free guidance 下,结果受无条件分支的影响非常大,并成功地利用这种影响达到了重建输入图像的目的。换句话说,null-text inversion 可以看作是 DDIM inversion 在 classifier-free guidance 下的“修正”或“拓展”。另外,与 GAN inversion 不同,null-text inversion 改动的并不是传统意义上的隐变量

点击查看 Null-text Inversion 的生成样例(摘自官网)

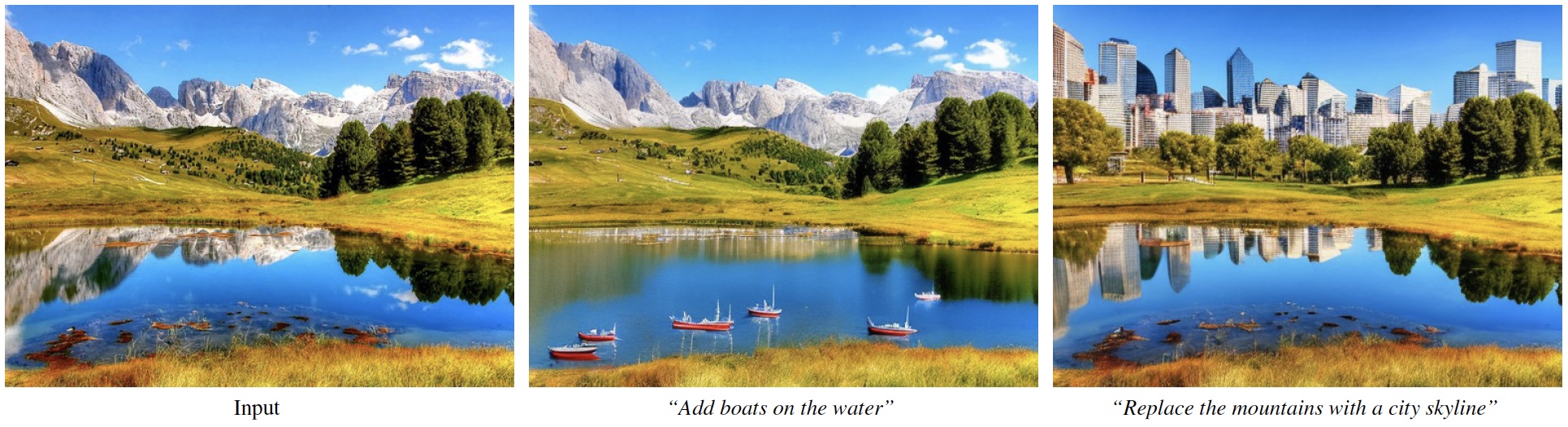

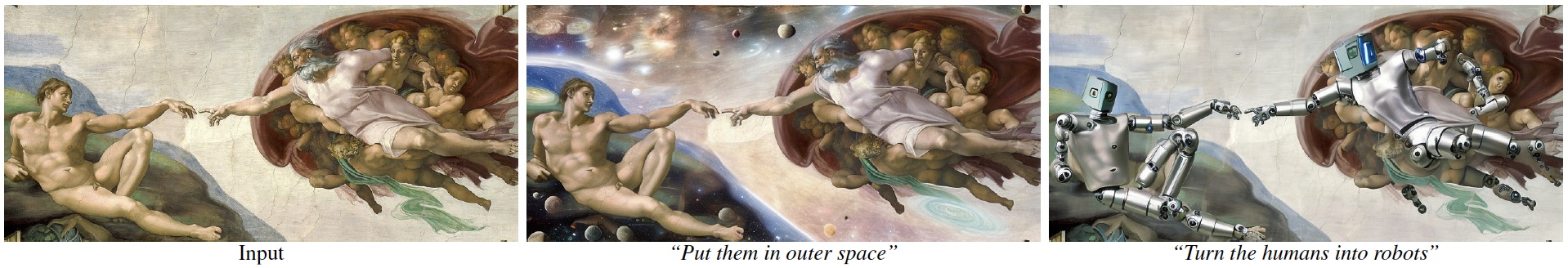

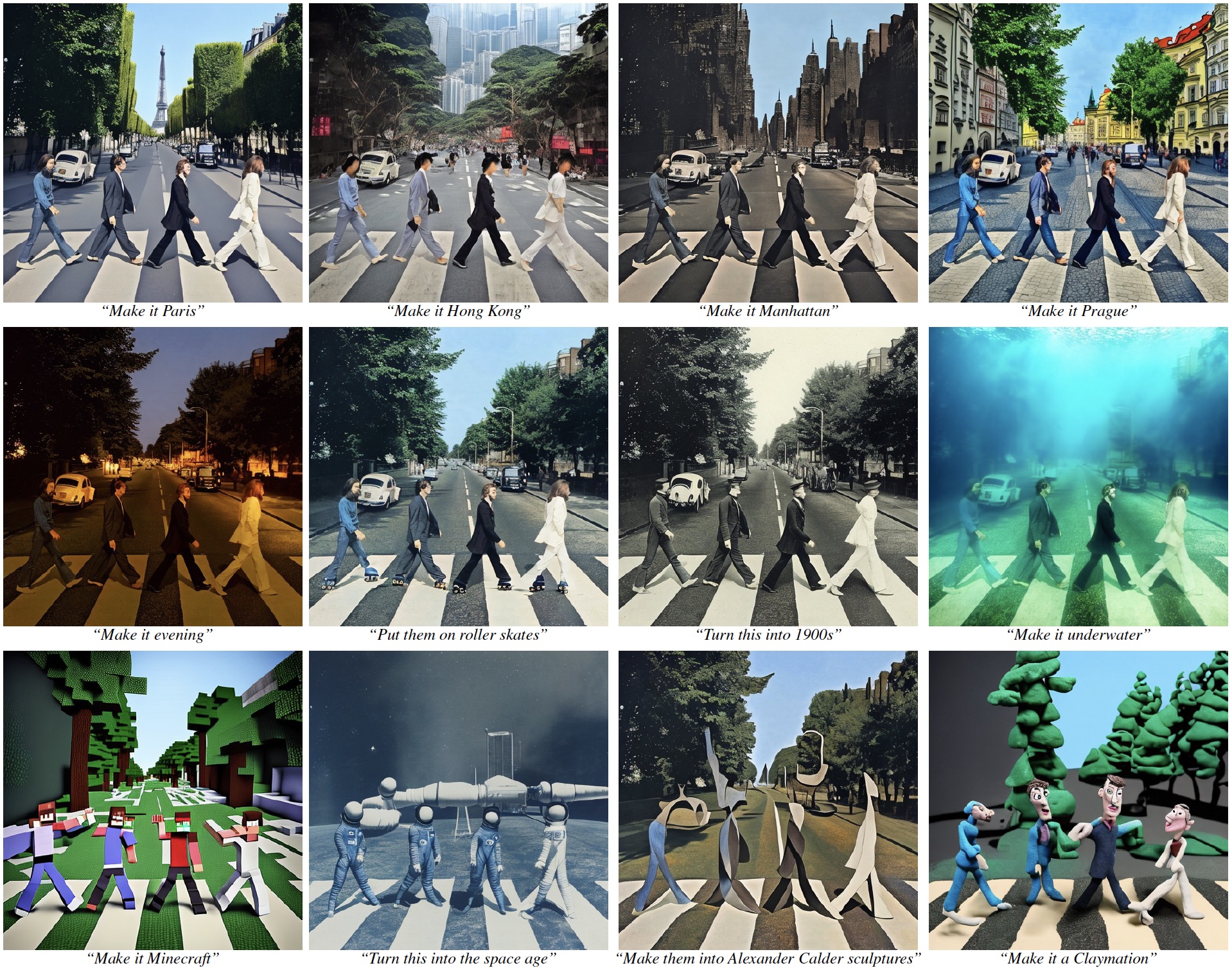

InstructPix2Pix

UCB 2022.11.17

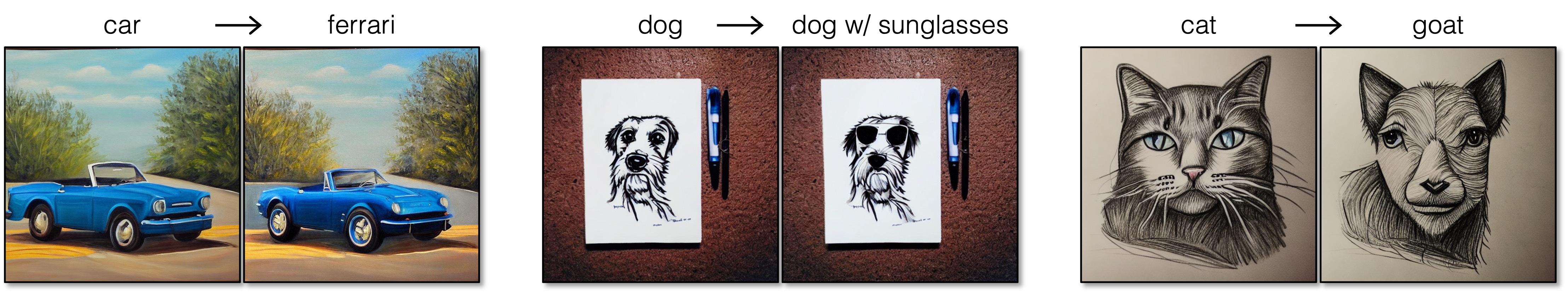

前文中,Prompt-to-Prompt[7] 和 DiffEdit[9] 虽然都实现了文本编辑图像的功能,但它们的模式是「把描述原图的文本编辑为描述目标图像的文本」,对用户而言这并不是很自然。最自然的方式应该是给指令,例如 "Color the cars pink"、"Make it lit by fireworks" 等。为此,UCB 的研究人员提出了 InstructPix2Pix[11].

其实 InstructPix2Pix 的技术路线非常直接——构造一个(源图像、编辑指令、目标图像)三元组构成的数据集,然后拿预训练的 Stable Diffusion 在上面微调。构造数据集的方式如下图左侧所示:

可以看到整体思路还是非常简单直接。先人为构造 700 条(源描述、编辑指令、目标描述)三元组构成的数据集,然后拿预训练的 GPT-3 在上面微调,使之能够根据源描述自动生成编辑指令和对应的目标描述。微调结束后,用 GPT-3 生成 450,000 多条数据,然后利用 Stable Diffusion 和 Prompt-to-Prompt 编辑方法分别生成源描述和目标描述对应的图像,这样就得到了用来训练的数据集。在这个数据集上微调 Stable Diffusion,将源图像和指令都作为模型的条件输入,即可让它遵循输入指令编辑图像了,如上图右侧所示。

众所周知,数据集的质量非常重要,因此作者用 Prompt-to-Prompt 时对每对文本描述都采用了不同的编辑强度生成了 100 对图像,然后用 directional CLIP similarity 做筛选。另外,由于模型输入有两个条件(源图像和编辑指令),所以采用 classifier-free guidance 时会有两个 guidace scale.

总而言之,InstructPix2Pix 虽然没有什么创新性 idea,但是非常实用。作者也在 HuggingFace Spaces 上放了一个 demo,可以随时玩耍。

点击查看 InstructPix2Pix 的生成样例(摘自官网)

Pix2pix-zero

CMU 2023.02.06

Pix2pix-zero 的目的是基于预训练的扩散模型通过文本来编辑真实图像,与 Null-text Inversion + Prompt-to-Prompt 比较相像,其方法如下图所示:

由图可见,pix2pix-zero 分为几个步骤——首先做 inversion 得到隐变量

要基于预训练扩散模型做编辑,就免不了要做隐空间 inversion. 最直接的方法显然是 DDIM inversion. 但是作者指出,网络的输出

具体而言,作者用一个自相关目标函数

寻找编辑方向

提出 cross-attention guidance 保留不希望编辑的部分的构图:作者发现 cross-attention map 对应着生成图像的构图,所以通过保证编辑前后 cross-attention map 的一致性,可以保留原始构图不变。这个 idea 与 Prompt-to-Prompt 很像,但是本文作者是通过 L2 loss 来约束的,相比 Prompt-to-Prompt 的直接修改更“软”。

算法伪代码如下:

总的来说,由于之前已经看过不少 zero-shot image-to-image translation 的工作了,所以这篇文章带来的新鲜感没有那么强,但是也不失为一个很好的工作。

点击查看 pix2pix-zero 的生成样例(摘自官网)

References

- Kim, Gwanghyun, Taesung Kwon, and Jong Chul Ye. Diffusionclip: Text-guided diffusion models for robust image manipulation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 2426-2435. 2022. ↩︎

- Avrahami, Omri, Dani Lischinski, and Ohad Fried. Blended diffusion for text-driven editing of natural images. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 18208-18218. 2022. ↩︎

- Liu, Xihui, Dong Huk Park, Samaneh Azadi, Gong Zhang, Arman Chopikyan, Yuxiao Hu, Humphrey Shi, Anna Rohrbach, and Trevor Darrell. More control for free! image synthesis with semantic diffusion guidance. In Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision, pp. 289-299. 2023. ↩︎

- Nichol, Alex, Prafulla Dhariwal, Aditya Ramesh, Pranav Shyam, Pamela Mishkin, Bob McGrew, Ilya Sutskever, and Mark Chen. Glide: Towards photorealistic image generation and editing with text-guided diffusion models. arXiv preprint arXiv:2112.10741 (2021). ↩︎

- Song, Yang, and Stefano Ermon. Generative modeling by estimating gradients of the data distribution. Advances in neural information processing systems 32 (2019). ↩︎

- Choi, Jooyoung, Sungwon Kim, Yonghyun Jeong, Youngjune Gwon, and Sungroh Yoon. ILVR: Conditioning Method for Denoising Diffusion Probabilistic Models. In 2021 IEEE/CVF International Conference on Computer Vision (ICCV), pp. 14347-14356. IEEE, 2021. ↩︎

- Hertz, Amir, Ron Mokady, Jay Tenenbaum, Kfir Aberman, Yael Pritch, and Daniel Cohen-Or. Prompt-to-prompt image editing with cross attention control. arXiv preprint arXiv:2208.01626 (2022). ↩︎

- Kwon, Gihyun, and Jong Chul Ye. Diffusion-based image translation using disentangled style and content representation. arXiv preprint arXiv:2209.15264 (2022). ↩︎

- Couairon, Guillaume, Jakob Verbeek, Holger Schwenk, and Matthieu Cord. Diffedit: Diffusion-based semantic image editing with mask guidance. arXiv preprint arXiv:2210.11427 (2022). ↩︎

- Mokady, Ron, Amir Hertz, Kfir Aberman, Yael Pritch, and Daniel Cohen-Or. Null-text Inversion for Editing Real Images using Guided Diffusion Models. arXiv preprint arXiv:2211.09794 (2022). ↩︎

- Brooks, Tim, Aleksander Holynski, and Alexei A. Efros. Instructpix2pix: Learning to follow image editing instructions. arXiv preprint arXiv:2211.09800 (2022). ↩︎

- Parmar, Gaurav, Krishna Kumar Singh, Richard Zhang, Yijun Li, Jingwan Lu, and Jun-Yan Zhu. Zero-shot image-to-image translation. arXiv preprint arXiv:2302.03027 (2023). ↩︎